La Física de la Materia Condensada es el campo de la física que se ocupa de las características físicas macroscópicas de la materia. En particular, se refiere a las fases "condensadas" que aparecen siempre que el número de constituyentes en un sistema sea extremadamente grande y que las interacciones entre los componentes sean fuertes. Los ejemplos más familiares de fases condensadas son los sólidos y los líquidos, que surgen a partir de los enlaces y uniones causados por interacciones electromagnéticas entre los átomos. Entre las fases condensadas más exóticas se cuentan las fases superfluidas y el condensado de Bose-Einstein, que se encuentran en ciertos sistemas atómicos sometidos a temperaturas extremadamente bajas, la fase superconductora exhibida por los electrones de la conducción en ciertos materiales, y las fases ferromagnética y antiferromagnética de espines en redes atómicas.

La Física de la Materia Condensada es, por lejos, el campo más extenso de la física contemporánea. Un enorme progreso ha sido realizado en la rama teórica de la física de la materia condensada. Para una estimación, un tercio de todos los físicos americanos se identifica a sí mismo como físicos trabajando en temas de la materia condensada. Históricamente, dicho campo nació a partir de la física del estado sólido, que ahora es considerado como uno de sus subcampos principales. El término "física condensada de la materia" fue acuñado, al parecer, por Philip Anderson, cuando renombró a su grupo de investigación - previamente "teoría del estado sólido" - (1967). En 1978, la División de Física del Estado Sólido de la American Physical Society fue renombrada como División de Física de Materia Condensada. El campo de estudio de la física de la materia condensada tiene una gran superposición con áreas de estudio de la química, la ciencia de materiales, la nanotecnología y la ingeniería.

Una de las razones para que la "física de materia condensada" reciba tal nombre es que muchos de los conceptos y técnicas desarrollados para estudiar sólidos se aplican también a sistemas fluidos. Por ejemplo, los electrones de conducción en un conductor eléctrico forman un tipo de líquido cuántico que tiene esencialmente las mismas características que un fluido conformado por átomos. De hecho, el fenómeno de la superconductividad, en el cual los electrones se condensan en una nueva fase fluida en la cual puedan fluir sin disipación, presenta una gran analogía con la fase superfluida que se encuentra en el helio-3 a muy bajas temperaturas.

Un sólido cristalino es aquél que tiene una estructura periódica y ordenada, como consecuencia tienen una forma que no cambia, salvo por la acción de fuerzas externas. Cuando se aumenta la temperatura, los sólidos se funden y cambian al estado líquido. Las moléculas ya no permanecen en posiciones fijas, aunque las interacciones entre ellas sigue siendo suficientemente grande para que el líquido pueda cambiar de forma sin cambiar apreciablemente de volumen, adaptándose al recipiente que lo contiene.

sólido amorfo es a sólido en cuál allí es no orden de largo alcance de las posiciones del átomos. (Los sólidos en que allí son orden atómica de largo alcance se llaman sólidos cristalinos o morphous). La mayoría de las clases de materiales sólidos se pueden encontrar o preparar en una forma amorfa. Por ejemplo, ventana común cristal es un amorfo de cerámica, muchos polímeros (por ejemplo poliestireno) son los alimentos amorfos, y uniformes por ejemplo caramelo de algodón son los sólidos amorfos.

En el principio, dado una tarifa que se refresca suficientemente alta, cualquier líquido se puede hacer en un sólido amorfo. El refrescarse reduce movilidad molecular. Si la tarifa que se refresca es más rápida que la tarifa en la cual las moléculas pueden organizar en más termodinámico el estado cristalino favorable, entonces un sólido amorfo será formado. Debido a consideraciones de la entropía, muchos polímeros se pueden hacer los sólidos amorfos refrescándose incluso en las tarifas lentas. En cambio, si las moléculas tienen suficiente tiempo para organizar en una estructura con dos u orden tridimensional, entonces un sólido cristalino (o semi-cristalino) será formado. El agua es un ejemplo. Debido a su tamaño y capacidad moleculares pequeños de cambiar rápidamente, no puede ser hecho amorfo sin el recurso a las técnicas hyperquenching especializadas.

Los materiales amorfos se pueden también producir por los añadidos que interfieren con la capacidad del componente primario de cristalizarse. Por ejemplo, adición de soda a dióxido del silicio resultados en cristal de la ventana, y la adición de glicoles a agua resultados en a vitrified sólido.

Los cristales líquidos son apreciados por sus singulares propiedades ópticas y de autorreparación. Generalmente consisten en moléculas de formas especiales que se alinean en el estado líquido por su forma. Usando campos eléctricos para manipular la orientación de las moléculas de cristal líquido, los científicos pueden controlar si la luz puede o no atravesar el material líquido cristalino. Sin los cristales líquidos, artículos que consideramos cotidianos como las pantallas planas de numerosos aparatos, o los relojes con display LCD, no existirían.

Los cristales líquidos más conocidos son moléculas orgánicas compuestas de carbono, nitrógeno y oxígeno. Agregar materiales inorgánicos, o metales, a estos cristales líquidos para acceder a sus propiedades eléctricas o magnéticas era problemático porque la estructura de estas moléculas hace difícil lograr las altas concentraciones metálicas necesarias para que sean útiles.

Conducción Eléctrica De Los Materiales : No todos los materiales conducen la electricidad de la misma forma. Para diferenciarlos, decimos que algunos presentan mayor "resistencia" que otros a conducir la electricidad.

La resistencia eléctrica es una medida cuantitativa respecto de cuán buen conductor es un material. La resistencia eléctrica se mide en ohmios, en honor a Georg Simon Ohm (1787-1854), que desarrolló los principios agrupados en la ley de Ohm (ver recuadro). A los materiales que presentan baja resistencia eléctrica se les llama buenos conductores eléctricos. A su vez, a aquellos que poseen alta resistencia eléctrica se les denomina malos conductores eléctricos. Cambios en la resistencia ¿Qué puede hacer cambiar la resistencia eléctrica en un material conductor? Volvamos a nuestro modelo del "juego de las manzanas verdes". Si permitimos que más individuos se incorporen al juego y, de este modo, aumentamos la longitud del grupo en relación al campo de juego, ¿qué sucederá con la conducción de las manzanas? Pues bien, dado que ahora existe una mayor cantidad de individuos a través de los cuales debe pasar cada manzana, observaremos que la conducción cambia. Esto, pues habiendo una mayor cantidad de personas, aumenta el número de manzanas que se caen al suelo, o bien el número de ellas que son mordisqueadas, lo que trae como consecuencia que la conducción empeore.

Por otra parte, si en vez de aumentar la longitud del grupo, aumentamos el espacio por donde pasarán las manzanas es decir, aumentamos el ancho, incorporando más jugadores distribuidos en el campo de juego, también observaremos que la conducción cambia. Puesto que, si bien en este caso, al aumentar la cantidad de individuos, es mayor la cantidad de manzanas que se caen al suelo o son mordisqueadas, a su vez es mayor también la cantidad de manzanas que circulan por el grupo, dado que al aumentar el ancho de este hay más personas sacando manzanas desde los cajones, con lo cual observaremos -contrario al caso anterior, donde solo saca manzanas quien está al comienzo de la fila de jugadores que la conducción de manzanas mejora.

Análogamente a nuestro modelo, en un material conductor la resistencia eléctrica aumenta mientras mayor sea el largo del conductor por el cual circula una corriente, y disminuye cuando aumenta el área de este.

La respuesta dielectrica: Se denomina dieléctricos a los materiales que no conducen la electricidad, por lo se pueden utilizar como aislantes eléctricos.

Algunos ejemplos de este tipo de materiales son el vidrio, la cerámica, la goma, la mica, la cera, el papel, la madera seca, la porcelana, algunas grasas para uso industrial y electrónico y la baquelita. Los dieléctricos se utilizan en la fabricación de condensadores, para que las cargas reaccionen. Cada material dieléctrico posee una constante dieléctrica k. que es conocida como la constante de proporcionalidad directa e inversamente proporcional hablando matematicamente

Tenemos k para los siguiente dieléctricos: vacío tiene k = 1; aire (seco) tiene k = 1,00059; teflón tiene k = 2,1; nylon tiene k = 3,4; papel tiene k = 3,7; agua tiene k = 80.

Los dieléctricos más utilizados son el aire, el papel y la goma.

El magnetismo es un fenómeno físico por el que los materiales ejercen fuerzas de atracción o repulsión sobre otros materiales. Hay algunos materiales conocidos que han presentado propiedades magnéticas detectables fácilmente como el níquel, hierro, cobalto y sus aleaciones que comúnmente se llaman imanes. Sin embargo todos los materiales son influenciados, de mayor o menor forma, por la presencia de un campo magnético.

También el magnetismo tiene otras manifestaciones en física, particularmente como uno de los dos componentes de la onda electromagnética, como, por ejemplo, la luz.

Expansión térmica: La mayoría de los sólidos se expanden cuando se calientan y se contraen cuando se enfrían.

Esta es una propiedad del material que es indicativa de la magnitud a la cual un material se expande bajo calentamiento y tiene unidades de temperatura recíproca (ºC)-1 ó (ºF)-1. Por supuesto el calentamiento ó el enfriamiento afecta toda las dimensiones de un cuerpo con un cambio en el volumen resultante.Desde el punto de vista atómico la expansión térmica se refleja por un incremento en el promedio de la distancia entre los átomos . Este fenómeno se puede entender mejor observando la curva de energía potencial versus espaciamiento interatómico para un material sólido.

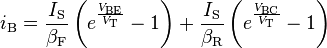

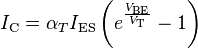

La figura se representa el modelo de pequeña señal de un FET constituido por dos parámetros: gm, o factor de admitancia, y rd, o resistencia de salida o resistencia de drenador. Esta notación es la más extendida para describir estos parámetros, aunque algunos fabricantes utilizan la notación en parámetros {Y} o {G}, denominando yfs o gfs a gm, e yos−1 o gos−1 o ross a rd.

La figura se representa el modelo de pequeña señal de un FET constituido por dos parámetros: gm, o factor de admitancia, y rd, o resistencia de salida o resistencia de drenador. Esta notación es la más extendida para describir estos parámetros, aunque algunos fabricantes utilizan la notación en parámetros {Y} o {G}, denominando yfs o gfs a gm, e yos−1 o gos−1 o ross a rd.

![J_p(Base) = \frac{q D_p p_{bo}}{W} \left[e^{\frac{V_{EB}}{V_T}}\right]](http://upload.wikimedia.org/math/9/6/f/96f699c8d9fe9e6f131c4966a5a128e2.png)